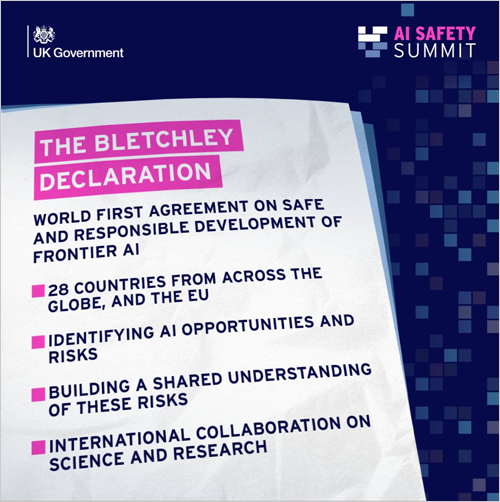

Los países convocados en la Cumbre sobre Seguridad de la Inteligencia Artificial, que se celebró la semana pasada en Bletchley Park (Reino Unido), firmaron la Declaración de Bletchley para un desarrollo seguro y responsable de la inteligencia artificial (IA), centrada en las personas y en beneficio de la comunidad global.

La Declaración de Bletchley establece un entendimiento y una responsabilidad compartida en torno a las oportunidades y los riesgos que plantean los modelos fronterizos de IA y la necesidad de que los gobiernos trabajen juntos en materia de investigación y seguridad, particularmente a través de una mayor colaboración científica, para hacer frente a los principales desafíos.

Los 28 firmantes son Australia, Brasil, Canadá, Chile, China, Unión Europea, Francia, Alemania, India, Indonesia, Irlanda, Israel, Italia, Japón, Kenia, Reino de Arabia Saudita, Países Bajos, Nigeria, Filipinas, República de Corea, Ruanda, Singapur, España, Suiza, Turquía, Ucrania, Emiratos Árabes Unidos, Reino Unido de Gran Bretaña e Irlanda del Norte y Estados Unidos.

Desafíos y oportunidades

La Declaración de Bletchley pretende promover el crecimiento económico inclusivo, el desarrollo sostenible y la innovación, proteger los derechos humanos y las libertades fundamentales, y fomentar la confianza en los sistemas de IA para aprovechar plenamente su potencial. Además, determina que deben abordarse aspectos como la transparencia, la equidad, la rendición de cuentas, la regulación, la supervisión humana, la ética, los prejuicios, la privacidad y la protección de datos.

Los firmantes aceptan la necesidad urgente de comprender y gestionar colectivamente los riesgos potenciales a través de un esfuerzo global conjunto para garantizar que la IA se desarrolla de forma segura y responsable. Coinciden en que pueden surgir riesgos sustanciales a partir de un posible uso indebido o de problemas no intencionados de control, y señalan una especial preocupación por la ciberseguridad, la biotecnología y la desinformación.

Debido a la necesidad de profundizar en la comprensión de los riegos y capacidades de estos modelos, también han acordado trabajar juntos para apoyar una red de investigación científica. Por otro lado, la Declaración reconoce que aquellos que desarrollan capacidades fronterizas de IA tienen la responsabilidad de garantizar la seguridad de estos modelos.

El enfoque regulatorio, de gobernanza y de innovación para maximizar los beneficios teniendo en cuenta los riesgos de la IA podría incluir la realización de clasificaciones y categorizaciones de riesgo basadas en las circunstancias nacionales y los marcos legales aplicables. También la cooperación, cuando corresponda, en principios y códigos de conducta comunes. En este sentido, es necesario involucrar a todos los agentes: países, foros internacionales y otras iniciativas, empresas, sociedad civil y mundo académico.

Abordar los riesgos de la IA

La agenda para abordar el riesgo de los modelos fronterizos de IA se centrará, por una parte, en identificar los riesgos de seguridad compartidos, construir una comprensión científica basada en la evidencia y mantener ese entendimiento a medida que las capacidades de esta tecnología van aumentando.

Por otra parte, se construirán políticas basadas en riesgos, colaborando cuando corresponda. Esto incluye una mayor transparencia por parte de los actores privados, métricas de evaluación, herramientas para pruebas de seguridad y el desarrollo de capacidades e investigaciones científicas del sector público. Para apoyar esta agenda, se respaldará una red internacional de investigación científica en IA.

Como parte del proceso de cooperación internacional recogido en la Declaración, se ha determinado que Corea será coanfitrión de una cumbre virtual sobre inteligencia artificial en los próximos seis meses y que Francia será la sede de la próxima cumbre presencial dentro de un año. Así, se busca garantizar una acción internacional continua para abordar los riesgos de la IA.